4 เซ็นเซอร์ในกล่องเดียว: เปิดศักยภาพ Azure Kinect v2 สำหรับโปรเจกต์ AR/VR และ Metaverse

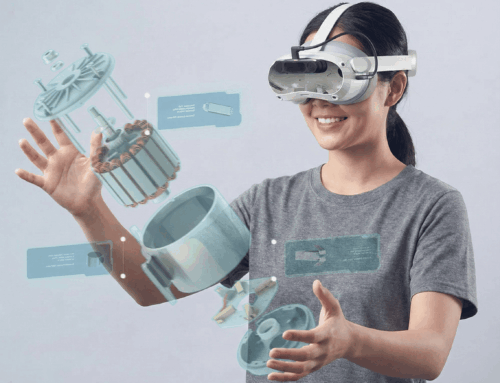

Azure Kinect v2 กำลังกลายเป็นหนึ่งในอุปกรณ์สำคัญสำหรับใครก็ตามที่ทำโปรเจกต์ด้าน AR, VR และ Metaverse เพราะมันไม่ได้เป็นแค่ “กล้องตัวหนึ่ง” แต่เป็นเซ็นเซอร์ 3 มิติเกรดนักพัฒนา ที่รวมทุกอย่างที่ต้องใช้ในการเข้าใจ “การเคลื่อนไหวและสภาพแวดล้อมจริง” ไว้ในกล่องเดียว ทั้งกล้อง RGB ความละเอียดสูง เซ็นเซอร์วัดความลึกแบบ Time‑of‑Flight (ToF) ไมโครโฟนอาร์เรย์ และ IMU สำหรับตรวจจับการเคลื่อนไหว. บทความนี้จะพาไปรู้จักว่า 4 เซ็นเซอร์หลักของ Azure Kinect v2 คืออะไร ทำอะไรได้ และจะเอาไปต่อยอดโปรเจกต์ AR/VR และ Metaverse ให้ “ขายงานลูกค้า” ง่ายขึ้นได้อย่างไร

Azure Kinect v2 คืออะไร และทำไมถึงสำคัญกับ AR/VR

Azure Kinect v2 (Azure Kinect DK) เป็นชุดเซ็นเซอร์ 3 มิติที่ออกแบบมาสำหรับนักพัฒนาและองค์กรที่ต้องการข้อมูลเชิงลึกทั้งภาพ สี เสียง และการเคลื่อนไหวจากโลกจริง เพื่อนำไปใช้ในงาน AI, Computer Vision, Motion Capture, Robotics และประสบการณ์เสมือนจริง. จุดเด่นคือสามารถดึงข้อมูลเชิงลึก (depth) ของฉาก ร่วมกับภาพสีความละเอียดสูงและข้อมูลท่าทางมนุษย์ เพื่อใช้สร้างสภาพแวดล้อมเสมือนหรือควบคุม avatar ใน Metaverse ได้อย่างเป็นธรรมชาติ.

สำหรับโลก AR/VR และ Metaverse ความต่างระหว่าง “กล้องธรรมดา” กับ “เซ็นเซอร์ระดับ Azure Kinect” คือ กล้องธรรมดาแค่ถ่ายภาพ แต่ Azure Kinect v2 “เข้าใจ” ระยะห่าง รูปร่าง และการเคลื่อนไหวของผู้ใช้ จึงสามารถนำไปใช้ทำ full‑body tracking, gesture control, volumetric capture และ interactive installation ได้ในตัวเดียว.

4 เซ็นเซอร์หลักใน Azure Kinect v2

1.กล้อง RGB ความละเอียดสูง

Azure Kinect v2 มาพร้อมกล้อง RGB ความละเอียดสูงสุดระดับ 12 ล้านพิกเซล รองรับการจับภาพสีที่คมชัด เหมาะกับงานที่ต้องการทั้งความสวยงามและข้อมูลภาพสำหรับประมวลผลร่วมกับ AI. สำหรับโปรเจกต์ AR/VR กล้อง RGB ใช้ทั้งเพื่อแสดงภาพจริง (เช่น MR, passthrough) และใช้เป็น input ให้โมเดล Machine Learning วิเคราะห์วัตถุหรือสภาพแวดล้อม.

2.เซ็นเซอร์ Depth แบบ Time‑of‑Flight (ToF)

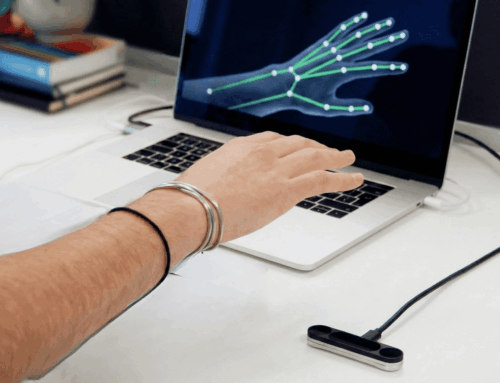

หัวใจหลักของ Azure Kinect v2 คือเซ็นเซอร์ depth ความละเอียดระดับ 1MP ที่ใช้เทคโนโลยี Time‑of‑Flight ซึ่งยิงลำแสงอินฟราเรดออกไปแล้ววัดเวลาสะท้อนกลับ เพื่อคำนวณระยะห่างของแต่ละพิกเซล. ข้อดีคือได้แผนที่ความลึกแบบละเอียด สามารถสร้าง point cloud หรือ mesh 3D ของร่างกายคนและสิ่งแวดล้อมได้อย่างแม่นยำ เหมาะกับโปรเจกต์อย่าง motion capture, body tracking, hand tracking, volumetric video และ spatial mapping ใน Metaverse.

3.ไมโครโฟนอาร์เรย์ (Microphone Array)

Azure Kinect v2 มีไมโครโฟนอาร์เรย์หลายตัว (เช่น 7 ตัว) จัดวางเป็นรูปแบบ beamforming ทำให้สามารถจับเสียงทิศทางและลดเสียงรบกวนได้ดีกว่าไมค์เดี่ยว. เมื่อนำไปใช้ร่วมกับบริการ Speech to Text หรือ Voice Command บนคลาวด์ จะสามารถสร้างระบบโต้ตอบด้วยเสียงใน AR/VR และ Metaverse เช่น สั่ง avatar เดิน พูด หรือสลับซีน เพียงใช้เสียงผู้ใช้. สำหรับการออกแบบประสบการณ์ผู้ใช้ การมีไมโครโฟนอาร์เรย์ในตัวช่วยลดการพึ่งพาไมค์เสริม และเพิ่มความเป็น “natural interface” มากขึ้นอย่างชัดเจน.

4.IMU (Inertial Measurement Unit)

IMU ใน Azure Kinect v2 ประกอบด้วย accelerometer และ gyroscope ที่ใช้ตรวจจับการเคลื่อนไหวของตัวเซ็นเซอร์เอง. ในโปรเจกต์ AR/VR ข้อมูลจาก IMU ช่วยเรื่องการคาลิเบรต การจับการเคลื่อนที่ของเซ็นเซอร์เมื่อย้ายตำแหน่ง หรือใช้ร่วมกับข้อมูล depth เพื่อรักษาความเสถียรของการ tracking. ถ้าต้องติด Azure Kinect บนแพลตฟอร์มที่เคลื่อนที่ เช่น หุ่นยนต์, dolly, แขนกล หรือ rig ในสตูดิโอ ข้อมูล IMU จะช่วยให้ระบบสามารถชดเชยการสั่นและการเอียงได้ดียิ่งขึ้น.

ทำไม “4 เซ็นเซอร์ในกล่องเดียว” ถึงตอบโจทย์ AR/VR และ Metaverse

ข้อได้เปรียบเชิงธุรกิจของ Azure Kinect v2 คือการรวมทุกอย่างไว้ในอุปกรณ์เดียว ลดจำนวนฮาร์ดแวร์ที่ต้องติดตั้ง ลดปัญหาการคาลิเบรตระหว่างอุปกรณ์หลายชิ้น และลดต้นทุนการพัฒนา. นักพัฒนาสามารถใช้ SDK เดียวเข้าถึงทั้ง RGB, depth, audio และ IMU พร้อมกัน แล้วผนวกเข้ากับเอนจินอย่าง Unity, Unreal Engine หรือแพลตฟอร์ม VR/AR อื่น ๆ ได้รวดเร็ว.

สำหรับ use case ใน Metaverse การมีทั้ง depth และ body tracking ช่วยให้สร้าง avatar ที่ขยับตามร่างกายผู้ใช้จริงได้แบบเรียลไทม์ โดยไม่ต้องพึ่งชุด mocap ราคาแพง. ขณะเดียวกัน ไมโครโฟนอาร์เรย์และการต่อยอดด้วยบริการ Speech และ Cognitive Services ทำให้สามารถออกแบบโลกเสมือนที่รองรับการป้อนคำสั่งด้วยท่าทางและเสียงพร้อมกัน ทำให้ประสบการณ์ผู้ใช้ดู “เหนือจริง” แต่ใกล้เคียงการปฏิสัมพันธ์ตามธรรมชาติ.

นอกจากนี้ Azure Kinect v2 ยังรองรับการซิงก์หลายตัวพร้อมกันผ่านพอร์ต sync เพื่อให้จับมุมมองจากหลายด้าน สร้าง volumetric capture หรือพื้นที่อินเทอร์แอคทีฟที่ครอบคลุมบริเวณขนาดใหญ่ เช่น เวทีอีเวนต์ พื้นที่โชว์รูม หรือโซนเล่นเกม VR แบบ free‑roam. นี่คือจุดขายที่ธุรกิจด้านอีเวนต์ สตูดิโอคอนเทนต์ 3D และผู้พัฒนา Metaverse สามารถใช้เป็น key message กับลูกค้าได้ทันที.