โลก AI กำลังก้าวไป... แต่โต๊ะทำงานของคุณ "ตามทัน" หรือยัง? รู้จัก DGX Spark ก่อนคู่แข่ง

สวัสดีครับ! ถ้าคุณคลิกเข้ามาอ่านบทความนี้ ผมพนันได้เลยว่าคุณคือหนึ่งในคนที่กำลัง “ปลุกปั้น” อะไรสักอย่างเกี่ยวกับ AI (ปัญญาประดิษฐ์) อยู่ ไม่ว่าคุณจะเป็น Data Scientist ที่กำลังพยายามเทรนโมเดลให้แม่นยำที่สุด, เป็น AI Developer ที่กำลังสร้างแอปฯ สุดล้ำ, หรืออาจจะเป็น CTO ของสตาร์ทอัปที่กำลังมองหา “ความได้เปรียบ” ที่จะทำให้ทีมของคุณวิ่งไวกว่าคู่แข่ง

เราทุกคนเห็นตรงกันว่าโลกของ AI มันวิ่งเร็วชนิดที่ว่า “กระพริบตาทีเดียว…ตกรถ” ได้เลย เมื่อวานเรายังทึ่งกับโมเดลภาษา (LLM) ที่มี 10 พันล้านพารามิเตอร์ วันนี้เราคุยกันที่หลักล้านล้านพารามิเตอร์แล้ว

แต่ท่ามกลางความตื่นเต้นนี้ มันมี “ความจริงที่เจ็บปวด” ซ่อนอยู่ที่โต๊ะทำงานของเราครับ…

เคยไหมครับ? นั่งจ้องหน้าจอตอนตี 3 แล้วเจอข้อความเจ้ากรรม… “CUDA out of memory”

นั่นแหละครับ คือสัญญาณว่า “โต๊ะทำงาน” หรือ Workstation ที่เรารักนักรักหนา มันกำลัง “ตามไม่ทัน” โลก AI ที่วิ่งแซงไปไกลแล้ว วันนี้ผมเลยอยากมาชวนคุยเรื่อง “ของเล่น” ชิ้นใหม่ (ที่จริงๆ แล้วไม่ใช่ของเล่น) ที่ชื่อว่า NVIDIA DGX Spark ที่อาจจะเป็นคำตอบว่าทำไมทีม AI ของคู่แข่งคุณ จู่ๆ ก็ปล่อยของใหม่ออกมาได้ไวกว่าที่คุณคิด

"นรกบนโต๊ะทำงาน" – ปัญหาคลาสสิกที่คนทำ AI เท่านั้นที่เข้าใจ

ก่อนที่เราจะไปพูดถึง DGX Spark ผมขอ “รีวิว” ประสบการณ์ที่เราๆ ท่านๆ น่าจะเจอกันอยู่เป็นประจำก่อนครับ เราเรียกมันว่า “กำแพงที่มองไม่เห็น” ของการพัฒนา AI ด้วยเครื่อง Workstation ทั่วไป (แม้ว่าจะเป็นเครื่องที่เรา “ประกอบเองสุดเทพ” ก็ตาม)

"สงครามไดรเวอร์" และ "นรก Dependency"

นี่คือเรื่องจริงยิ่งกว่านิยายครับ คุณลงการ์ดจอ NVIDIA ตัวใหม่มา…

ไดรเวอร์เวอร์ชันนี้… ดันไม่ซัพพอร์ต CUDA Toolkit ที่คุณต้องใช้

พออัปเดต CUDA… อ้าว PyTorch เวอร์ชันเก่าที่คุณรันโปรเจกต์เดิมอยู่ ดันไม่รองรับ

พออัปเดต PyTorch… อ้าว Library อื่นๆ ที่จำเป็น (เช่น cuDNN, NCCL) พังตามกันเป็นทอดๆ

แทนที่เราจะได้ใช้สมองไปกับการคิดค้น Algorithm ใหม่ๆ เรากลับต้องเสียเวลาเป็นวันๆ (หรือเป็นสัปดาห์!) ไปกับการเป็น “ผู้ดูแลระบบ” (SysAdmin) จำเป็น เพื่อให้ทุกอย่างมัน “ยอม” ทำงานร่วมกันได้

กำแพง VRAM ที่มองไม่เห็น

“ผมใช้ RTX 4090 มี VRAM 24GB แล้วนะ!” …ใช่ครับ มันเยอะมากสำหรับการเล่นเกม 8K แต่สำหรับการเทรนโมเดล AI สมัยใหม่ 24GB คือ “แทบไม่พอ” ครับ

โมเดลที่ใหญ่ขึ้น: โมเดลตระกูล GPT, Llama, หรือโมเดลด้านภาพอย่าง Stable Diffusion XL ต้องการ VRAM มหาศาลในการเทรน

Batch Size: อยากให้โมเดลเรียนรู้ได้ดีขึ้น ก็ต้องเพิ่ม Batch Size (ขนาดข้อมูลที่ป้อนต่อรอบ) ซึ่งก็กิน VRAM เพิ่ม

ผลลัพธ์: เราต้อง “ประนีประนอม” ลดขนาดโมเดล, ลด Batch Size, หรือใช้เทคนิคที่ซับซ้อนอย่าง Model Parallelism ซึ่งทั้งหมดนี้ทำให้การทดลองช้าลงและยุ่งยากขึ้น

"ภาษีแห่งการรอคอย"

นี่คือต้นทุนที่แพงที่สุดครับ… “เวลา” ลองนึกภาพตามนะครับ:

คุณมีไอเดียสุดเจ๋ง 2 ไอเดีย คุณอยากทดลองว่าแบบ A หรือ B ดีกว่ากัน

เครื่องปัจจุบัน: รันโมเดล A… “รอ 3 วัน” / รันโมเดล B… “รออีก 3 วัน”

สรุป: 1 สัปดาห์ผ่านไป คุณเพิ่งได้คำตอบแรก

แต่ถ้าคุณมีเครื่องที่รันโมเดล A จบใน 6 ชั่วโมง และรัน B จบใน 6 ชั่วโมง… คุณสามารถทดลองไอเดียได้ วันละ 2 ไอเดีย ไม่ใช่สัปดาห์ละ 2 ไอเดีย

ในขณะที่คุณ “รอ” คู่แข่งของคุณ “ทดลอง” ไปแล้ว 10 รอบ และนั่นคือจุดที่ DGX Spark ก้าวเข้ามา

DGX Spark คืออะไร? (คำเตือน: มันไม่ใช่ "PC ประกอบ")

เอาล่ะครับ มาถึงพระเอกของเรา หลายคน (รวมถึงผมในตอนแรก) พอได้ยินชื่อ DGX Spark ก็อาจจะคิดว่า “อ๋อ… มันคือ PC ประกอบสุดแรงที่ NVIDIA จัดสเปคมาให้ใช่ไหม?”

คำตอบคือ “ไม่ใช่” เลยครับ

DGX Spark ไม่ใช่ “คอมพิวเตอร์” (Computer) แต่มันคือ “ระบบ AI สำเร็จรูป” (Integrated AI System) ที่ย่อส่วนพลังของ “ซูเปอร์คอมพิวเตอร์” ใน Data Center มาไว้ใต้โต๊ะทำงานของคุณ (หรือข้างๆ โต๊ะ เพราะมันก็ใหญ่พอตัว!)

ความต่างมันอยู่ที่คำว่า “Integrated System” นี่แหละครับ

หัวใจของมัน: Hardware ที่สร้างมาเพื่องาน (Purpose-Built Hardware)

ถ้าเราผ่า DGX Spark ออกมาดู (ซึ่งเราไม่ทำ!) เราจะเจอของที่ไม่เหมือน PC ทั่วไป:

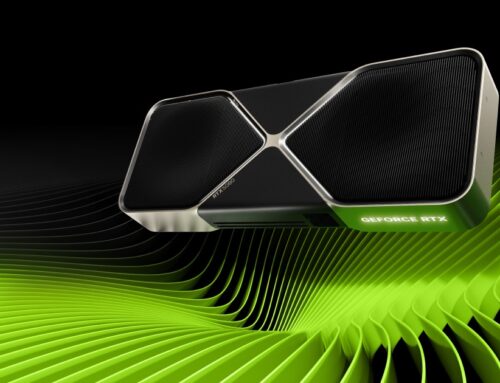

GPUs ระดับ Enterprise: มันไม่ได้ใช้การ์ดจอ GeForce ครับ แต่มันใช้ GPU ระดับ Data Center เช่น NVIDIA H100 หรือ A100 Tensor Core GPUs (ปกติจะมา 4 ตัว)

VRAM มหาศาล: เราไม่ได้พูดถึง 24GB แต่เรากำลังพูดถึง 80GB… ต่อตัว! (4 ตัวก็ 320GB) โมเดลไหนที่ว่าใหญ่… เชิญเลยครับ

NVLink ความเร็วสูง: นี่คือทีเด็ด! ไม่ใช่ SLI แบบที่เกมเมอร์ใช้ แต่เป็นเทคโนโลยีที่เชื่อม GPU ทั้ง 4 ตัวให้ทำงาน “เสมือนเป็น GPU ยักษ์ตัวเดียว” ด้วยแบนด์วิดท์ที่สูงปรี๊ด ทำให้การเทรนโมเดลขนาดใหญ่ที่ต้องแบ่งกันรัน 4 GPU ทำได้เร็วมาก

ระบบเครือข่ายความเร็วสูง (Networking): มันมาพร้อมการเชื่อมต่อระดับ Data Center (เช่น InfiniBand หรือ Ethernet ความเร็วสูง) เพื่อให้การดึงข้อมูลขนาดใหญ่มาเทรนไม่เป็นคอขวด

"ซอสลับ" ที่แท้จริง: NVIDIA AI Enterprise (NVAIE)

นี่คือสิ่งที่ทำให้ DGX Spark “ไม่ใช่” PC ประกอบ และเป็นเหตุผลว่าทำไมการซื้อ H100 มาประกอบเองถึงไม่เหมือนกัน

ถ้า DGX Spark คือ “ร่างกาย” ที่แข็งแกร่ง… NVIDIA AI Enterprise (NVAIE) ก็คือ “สมอง” และ “ระบบประสาท” ที่สมบูรณ์แบบครับ

มันคือ “Software Stack” ที่ NVIDIA ปรุงมาให้จบแล้ว:

จบปัญหานรก Dependency: NVAIE คือชุดซอฟต์แวร์ที่รวมเอาไดรเวอร์, CUDA, cuDNN, Library ต่างๆ ที่ผ่านการ “ทดสอบและรับรอง” (Certified) มาแล้วว่าทำงานร่วมกันได้ดีที่สุด ลื่นที่สุด

Framework ที่ Optimize แล้ว: ไม่ว่าคุณจะใช้ TensorFlow, PyTorch, หรืออะไรก็ตาม NVAIE มีเวอร์ชันที่ถูก Optimize มาเพื่อดึงพลังของ H100 ออกมาได้ 100%

MLOps Tools: มันมาพร้อมเครื่องมือสำหรับ “การทำงานเป็นทีม” (MLOps) ช่วยให้ทีมของคุณแชร์ทรัพยากรเครื่อง, จัดการโมเดล, และ Deploy งานได้ง่ายขึ้น

Enterprise Support: นี่คือสิ่งที่นักประกอบคอมให้คุณไม่ได้… มีปัญหา? คุณโทรหา NVIDIA ได้เลย ไม่ต้องไปนั่งโพสต์ถามใน Reddit หรือ Stack Overflow

พูดง่ายๆ คือ DGX Spark เปลี่ยนสมการจาก “เสียเวลา 1 เดือนเพื่อ Setup เครื่อง” ไปเป็น “เสียบปลั๊ก… แล้วเริ่มเทรนโมเดลได้เลยภายใน 1 วัน”

เปรียบเทียบให้ชัด: DGX Spark vs. "PC ประกอบสุดเทพ"

เพื่อให้เห็นภาพมากขึ้น ผมขอทำตารางเปรียบเทียบ “ความเหมือนที่แตกต่าง” ระหว่างการพยายามประกอบ “PC เทพ” เอง กับการใช้ระบบ DGX Spark ครับ

| คุณสมบัติ (Feature) | "PC ประกอบสุดเทพ" (DIY AI Workstation) | NVIDIA DGX Spark |

|---|---|---|

| GPU | 1-2x GeForce RTX 4090 (Consumer) | 4x NVIDIA H100/A100 (Data Center) |

| รวม VRAM | 24GB - 48GB | 320GB (สำหรับ H100 80GB) |

| การเชื่อมต่อ GPU | PCIe (SLI/NVLink สำหรับเกมมิ่ง - ถ้ามี) | 4th-Gen NVLink (ความเร็วสูงมาก) |

| Software Stack | "นรก DIY" (ต้องหา-ลง-แก้เองทั้งหมด) | NVIDIA AI Enterprise (ติดตั้ง-รับรอง-Optimize มาครบ) |

| เวลา Setup | หลายวัน ถึง หลายสัปดาห์ (ถ้าเจอปัญหา) | ไม่กี่ชั่วโมง (Plug-and-Play) |

| การสนับสนุน (Support) | "ตัวเอง" และ Community ออนไลน์ | NVIDIA Enterprise Support (ติดต่อผู้เชี่ยวชาญโดยตรง) |

| การทำงานเป็นทีม (MLOps) | ทำได้ยาก (ต้อง Setup เองทั้งหมด) | ออกแบบมาเพื่อ MLines (มีซอฟต์แวร์จัดการ) |

| เหมาะสำหรับ | Hobbyist, Freelancer, งานที่ไม่ใหญ่มาก | AI Startups, ทีม R&D, มหาวิทยาลัย, งานที่ต้องการความเร็ว |

รีวิวประสบการณ์ (จำลอง): จาก "กล่อง" สู่ "การเทรนโมเดล"

โอเค… ถ้าเรามี DGX Spark มาวางที่ออฟฟิศ ประสบการณ์ “เชิงรีวิว” มันจะเป็นยังไง?

รายการ (List) 5 ขั้นตอนสู่ "Aha! Moment"

แกะกล่องและเสียบปลั๊ก (Unboxing & Setup): ยอมรับว่ามันหนักครับ! (ประมาณ 30-40 กก.) และมันไม่ได้ใช้ปลั๊กไฟบ้านธรรมดา อาจต้องใช้ปลั๊กไฟกำลังสูง (แบบที่ใช้กับแอร์หรือเซิร์ฟเวอร์) แต่พอเสียบแล้ว… มันคือ “เปิดเครื่อง”

เปิดเครื่องครั้งแรก (First Boot): นี่ไม่ใช่ Windows 11 ครับ แต่มันจะเป็น OS ที่พร้อมใช้งาน (เช่น Ubuntu) ที่มี NVIDIA AI Enterprise ติดตั้งมาให้แล้ว

เข้าถึงระบบ (Accessing): ทีมของคุณสามารถ SSH หรือเข้าผ่านหน้าเว็บ (Base Command Manager) เพื่อเริ่มใช้งานได้ทันที ไม่ต้องลงไดรเวอร์ใดๆ

รัน Container แรก (First Container): คุณไม่ต้อง

pip installอะไรให้วุ่นวาย คุณแค่ไปที่คลังของ NVIDIA (เรียกว่า NGC) แล้ว “ดึง” (Pull) Container ของ PyTorch หรือ TensorFlow เวอร์ชันที่ Optimize แล้ว มา-รัน-ได้-เลย“Aha! Moment”: คุณโยนโค้ดโมเดลตัวที่ใหญ่ที่สุดของคุณ ที่เคยรันแล้ว “CUDA out of memory” ตลอดบนเครื่องเก่า… …10 นาทีผ่านไป… …30 นาทีผ่านไป… …มันยังรันอยู่! แถมยังใช้ GPU VRAM ไปแค่ 30% นี่แหละครับ “Aha! Moment” ที่คุณเอาชนะกำแพงเดิมๆ ได้

มันเหมาะกับใคร? (และไม่เหมาะกับใคร?)

จาก “รีวิว” และสเปคทั้งหมด ผมค่อนข้างชัดเจนว่า…

เหมาะมากสำหรับ:

AI Startups: ที่ “Speed-to-Market” คือความเป็นความตายของบริษัท

ทีม R&D ในองค์กร: ที่ต้องการทดลองไอเดียใหม่ๆ โดยไม่ต้องรอคิวใช้ Cluster ส่วนกลาง

มหาวิทยาลัยและสถาบันวิจัย: ที่ต้องการเครื่องมืออันทรงพลังสำหรับนักวิจัยในการตีพิมพ์ผลงาน

อาจจะไม่เหมาะกับ:

Hobbyist หรือ นักศึกษา: ที่เพิ่งเริ่มต้นเรียนรู้ AI (ราคาไม่ไหวแน่นอนครับ)

Freelancer: ที่รับงานขนาดเล็ก-กลาง (ใช้ 4090 อาจจะคุ้มค่ากว่า)

องค์กรที่ใหญ่มาก: ที่มี Data Center และ DGX SuperPOD ของตัวเองอยู่แล้ว (DGX Spark จะเป็นเหมือนเครื่องสำหรับทีมย่อยๆ)

เคลียร์ทุกข้อสงสัยก่อนตัดสินใจ (DGX Spark Q&A)

หากสนใจใน Nvidia Dgx spark

สามารถติดต่อมาทาง LINE ID : @metaxr ได้เลยครับ

สรุป อัปเกรด "โต๊ะทำงาน" หรือ "อัปเกรดอนาคต" ของบริษัท?

กลับมาที่คำถามแรก… โลก AI กำลังก้าวไป… แต่โต๊ะทำงานของคุณ “ตามทัน” หรือยัง?

หลังจากที่ได้เจาะลึก DGX Spark ผมว่ามันให้คำตอบที่ชัดเจนมากว่า “โต๊ะทำงาน” หรือ Workstation แบบเดิมๆ มัน “ตามไม่ทัน” จริงๆ สำหรับงาน AI ที่ซับซ้อนในปัจจุบัน

การลงทุนใน DGX Spark มันไม่ใช่การ “ซื้อคอมใหม่” มันคือการ “ซื้อเวลา” ครับ…

ซื้อเวลาที่ทีมของคุณควรจะได้ใช้ไปกับการ “สร้างสรรค์” ไม่ใช่ “ซ่อมบำรุง”

ซื้อเวลาที่จะทำให้คุณ “ทดลอง” ไอเดียได้เร็วกว่าคู่แข่ง 10 เท่า

ซื้อเวลาที่จะทำให้คุณ “ชนะ” ในสงคราม AI นี้

ถ้าคุณคือองค์กรที่จริงจังกับ AI การที่คู่แข่งของคุณมี DGX Spark และเริ่ม “วิ่ง” ในขณะที่คุณยัง “คลาน” เพราะติดปัญหา “CUDA out of memory”… นั่นคือความเสี่ยงที่น่ากลัวที่สุดแล้วครับ

รู้จัก DGX Spark วันนี้… ก่อนที่คู่แข่งของคุณจะใช้มันแซงหน้าคุณไปในวันพรุ่งนี้ครับ!

ดูว่า NVIDIA DGX Spark กระตุ้นความตื่นเต้นให้กับชุมชน AI ได้อย่างไร รับชมนักวิจัย สตาร์ทอัพ และนักนวัตกรรม แกะกล่องพลังในการสร้างต้นแบบ ปรับแต่ง และปรับใช้โปรเจกต์ AI ขนาดใหญ่ได้จากเดสก์ท็อปของพวกเขา